Generisches Set von Erfolgskriterien

Erfolgskriterien

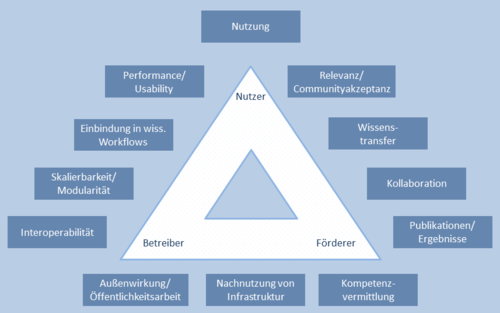

Die in der unten stehenden Abbildung dargestellten Erfolgskriterien ergeben eine fallspezifisch anzupassende Bewertungsschablone. Fallspezifisch bedeutet, dass zum einen die Auswahl der einzelnen Kriterien variiert werden kann („Menükarte“) und zum anderen, dass diese Auswahl um fachspezifische Kriterien ergänzt werden kann. Dieses Vorgehen trägt dem Umstand Rechnung, dass beispielsweise eine astrophysikalische Virtuelle Forschungsumgebung (VRE) andere fachspezifische Erfolgskriterien haben mag als eine geisteswissenschaftliche VRE. Die Erfolgskriterien zielen insbesondere auf den Nutzen und Ertrag der VRE für die wissenschaftlichen Anwender ab. Im Vordergrund stehen dabei Kriterien, die sich aus der eingangs beschriebenen VRE-Definition herleiten lassen.

Die Darstellung gruppiert die Kriterien entlang der drei wichtigsten Akteursgruppen. Dadurch wird deutlich, dass je nach Akteur unterschiedliche Schwerpunkte für die Erfolgsbeurteilung gesetzt werden (Gewichtung der einzelnen Kriterien). Hinzu können – wie weiter oben ausgeführt – jeweils noch fach- oder fallspezifische Kriterien kommen. Die Kriterien im Einzelnen:

- Nutzung: Welche Intensität und welchen Umfang hat die Nutzung der VRE durch die Zielgruppe? Unterscheiden sich der Nutzungsumfang bestimmter Komponenten einer VRE? Wieviele Nutzer hat die VRE in Relation zur Gesamtgröße der potenziellen Nutzergruppe? Für welche Abschnitte ihrer wissenschaftlichen Arbeitsprozesse nutzen die Wissenschaftler die VRE?

- Relevanz/Community-Akzeptanz: Wie sichtbar ist die VRE innerhalb der potenziellen Nutzergruppe? Wie bewertet diese den Nutzen der VRE für ihre Disziplin? Wird die VRE als potenziell nützlicher Beitrag zum Fach gesehen? Erzielt die VRE eine Wirkung außerhalb der Fachcommunity?

- Wissenstransfer: Inwiefern trägt die VRE – abgesehen von konkreten Forschungsergebnissen – zu einer Wissensvermehrung in der Disziplin bei, beispielsweise durch einen Erfahrungsaustausch über Methoden und Arbeitsziele oder eine öffentlich verfügbare Projektdokumentation?

- Kollaboration: Welche Formen der Zusammenarbeit mit anderen Forschern ermöglicht die Infrastruktur und wie weit werden diese praktisch ausgefüllt? In welchem Umfang sind die Kollaborationsmöglichkeiten Alleinstellungsmerkmale gegenüber anderen Infrastrukturen?

- Publikationen/Ergebnisse: Wie viele und welche Arten von Publikationen und Ergebnissen werden im Rahmen der VRE-Nutzung veröffentlicht? Können alle Publikationen und Ergebnisse der VRE eindeutig zugeordnet werden? Dieses Kriterium hängt natürlich auch eng mit der fachspezifischen Publikationskultur zusammen.

- Kompetenzvermittlung: In welchem Umfang trägt die VRE zu einer Kompetenzvermittlung innerhalb ihrer Nutzercommunity bei? Klassischerweise fallen hierunter etwa wissenschaftliche Qualifikationen wie Promotionen oder Abschlussarbeiten, ebenso aber die Vermittlung nicht wissenschaftsbezogener Kompetenzen. Dieses Kriterium deckt den Bereich ab, der üblicherweise als Lehre bezeichnet wird, wohingegen die anderen ergebnisorientierten Kriterien den Bereich Forschung abdecken.

- Nachnutzung von Infrastruktur: Werden Infrastrukturkomponenten der VRE in anderen Zusammenhängen genutzt oder werden nach der Abwicklung der VRE ausgewählte Komponenten in andere Zusammenhänge überführt? Dieses Kriterium umfasst auch Qualität und Umfang von Dokumentationen und die Bereitstellung von Informationen, Erkenntnissen und Ergebnissen.

- Außenwirkung/Öffentlichkeitsarbeit: Wie erfolgreich ist die Öffentlichkeitsarbeit einer VRE? Dabei sind verschiedene Ziele zu unterscheiden, bspw. Sichtbarkeit in der potenziellen Nutzergruppe, Vermittlung der VRE an die Förderer oder Wahrnehmung der VRE in der allgemeinen Öffentlichkeit oder anderen Fachdisziplinen.

- Interoperabilität: Setzt die VRE in den Forschungsprozessen etablierte Standards ein? Dies ist auch mit Blick auf die spätere Nachnutzbarkeit wichtig, d.h. hier begangene Fehler sind im späteren Verlauf nur schwer auszugleichen.

- Skalierbarkeit/Modularität: Wie anpassbar ist die Infrastruktur im Sinne einer Erweiterung der Nutzergruppe oder der Forschungsfragestellungen? Ist die Architektur der VRE von Anfang an darauf angelegt, in anderen Zusammenhängen zumindest teilweise nachgenutzt werden zu können?

- Einbindung in wissenschaftliche Workflows: Welche Abschnitte der wissenschaftlichen Arbeitsprozesse der Nutzergruppe deckt die VRE ab? Dabei kann es eher von Vorteil sein, keinen allzu umfänglichen Anspruch zu stellen, sondern sich auf ausgewählte Abschnitte der Workflows zu konzentrieren.

- Performance/Usability: Erfüllt die VRE die Ansprüche der Nutzer an die Erlernbarkeit und Bedienbarkeit? Passt sie sich nahtlos in den Arbeitsalltag der Forscher ein? Wie wird die Usability der VRE im Vergleich zu anderen (generischen) Werkzeugen bewertet?

Meilensteine

Die Erfolgskriterien können fallspezifisch unterschiedlich gewichtet werden. Es geht dabei nicht um eine quantitative Messbarkeit suggerierende Erhebung, sondern vielmehr um die Definition von Zielvorgaben. An der Erreichung dieser Vorgaben lässt sich dann zu einem späteren Zeitpunkt der Erfolg der VRE festmachen. Ein wichtiges Instrument bei der Operationalisierung der Erfolgskriterien können Meilensteine sein, die im folgenden Kapitel beschrieben werden.

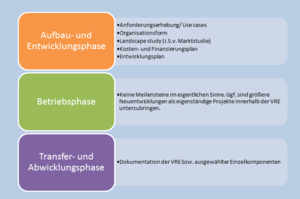

Während der Diskussion der oben beschriebenen Erfolgskriterien mit den verschiedenen Akteuren im Bereich VRE wurde schnell klar, dass diese eher abstrakt formulierten Kriterien eng mit konkreten Meilensteinen zusammenhängen. In diesem Sinne stellen die Meilensteine die Erfolgskriterien der einzelnen Lebensphasen in eine zeitliche Ordnung und verbinden sie mit spezifischen Aufgabenstellungen für den Betreiber der VRE. Das Fehlen solcher Meilensteine oder ihr Nichterreichen kann als ein „Misserfolgskriterium” (negatives Erfolgskriterium) gewertet werden. Die formale und inhaltliche Beurteilung der Meilensteine stellt einen weiteren Schritt der qualitativen Bewertung dar.

Eine Aufstellung dieser Meilensteine ist in der oben stehenden Abbildung skizziert. Diese Zusammenstellung ist als Vorschlag zu verstehen, da im Einzelfall nicht nur abweichende Meilensteine denkbar sind, sondern ebenso eine stärkere Strukturierung der einzelnen Meilensteine. Dem schon bei der Diskussion der Lebensphasen verwendeten Ansatz folgend, sind in der Entwicklungs- und Aufbauphase wesentlich mehr Meilensteine erforderlich als in den nachfolgenden Phasen.

Von zentraler Bedeutung für den Erfolg einer VRE ist die bereits zu Beginn erfolgende Einbindung der Nutzergruppe durch die Entwickler und Betreiber. Diese Einbindung findet im Rahmen der Anforderungserhebung (Bedarfs- und Marktanalyse) und im begleitenden Projektmonitoring statt. Damit soll eine größtmögliche Übereinstimmung zwischen den Anforderungen der Nutzergruppe (Nachfrage) und dem späteren Angebot der Infrastruktur sichergestellt werden.

Zur Vermittlung daraus entstehender Zielkonflikte (bspw. „Wunschliste“ vs. begrenztes Entwicklungsbudget) werden ein Kosten- und Finanzierungsplan, ein Entwicklungsplan sowie ein Konzept zur Organisationsform abgeleitet. Vor allem durch eine angemessene Einbindung aller Stakeholder einer VRE in die Organisationsform wird ein beständiger Austausch ermöglicht. Gleichzeitig stellen die Organisationsform und der Kosten- und Finanzierungsplan auch mögliche Weichen für die zukünftige Nachhaltigkeit der Infrastruktur. In den im Rahmen des Projektes DFG-VRE geführten Expertengesprächen wurde immer wieder eine realistische Kosten- und Aufwandseinschätzung für den Aufbau einer VRE als problematisch bezeichnet. Generalisierende Angaben sind schwierig, es können aber sehr wohl in Abhängigkeit von den spezifischen Aufgaben und der Größe der Nutzergruppe bereits zu Beginn einigermaßen realistisch gewichtete Kostenstrukturen erarbeitet werden, die eine belastbare Orientierung für die finanzielle Planung bieten können.

Zusammenfassung

Zusammengefasst zeigen die Rückmeldungen aus der Community:

- Die Definition des Erfolgs einer VRE ist stark von der Akteurs- und Disziplinperspektive abhängig. Die vorliegende Arbeit setzt einen Schwerpunkt auf die Sicht der Entwickler und Betreiber.

- Die Definition von Erfolgskriterien für VREs ist mit erheblichen methodischen Herausforderungen verbunden, das heißt Erfolg ist nicht einfach quantifizierbar und vergleichbar.

- Es gibt kein allgemeingültiges Kriterienset für VREs. Vielmehr ist es sinnvoll, aus einem Kriterienkatalog fallspezifisch ein Set zusammenzustellen und dieses um fachspezifische Kriterien zu erweitern.

- Idealerweise erfolgt die Erfolgsdefinition in der Planungsphase einer VRE, das heißt vor der Aufbau- und Betriebsphase.

- Eine Analyse der VREs entlang eines Lebensphasenmodells ist sinnvoll, da sich Unterschiede hinsichtlich der Erfolgsbeurteilung nicht nur mit Blick auf die Fachrichtung, sondern auch auf die jeweils aktuelle Lebensphase ergeben. In unterschiedlichen Lebensphasen einer VRE können somit verschiedene Kriterien im Vordergrund stehen.

- Damit zusammenhängend gibt es über die Lebensphasen einer VRE hinweg erfolgskritische Wegpunkte, zusammengefasst in Form von Meilensteinen. Hier werden Parallelen zu Planung, Aufbau und Betrieb von anderen Formen von Infrastruktur deutlich. Die erfolgskritischen Wegpunkte während der Lebensphasen sind im Sinne einer fachgerechten Projektsteuerung zu verstehen.

- Definitionsfragen (bspw. virtuell oder kollaborativ) haben in der Praxis eine untergeordnete Bedeutung, wobei sich eine Entwicklung von einem umfassenden VRE-Ansatz, den gesamten Forschungsprozess abbildend, hin zu einem modularen, werkzeugorientierten Ansatz anzudeuten scheint.

- Ein werkzeugorientierter Ansatz hat gegenüber einem dem gesamten Forschungsprozess abdeckenden Ansatz Vorteile. Er konzentriert sich auf bestimmte Abschnitte des Forschungsprozesses und ist in der Lage, besser zwischen Community-“Nachfrage“ und Infrastruktur-“Angebot“ zu vermitteln. Er wird auch der Tatsache besser gerecht, dass generische Werkzeuge (bspw. Wiki, Clouddienste) in der Arbeitsumgebung der Forscher in der Regel bereits vorhanden sind, gegen die generische Werkzeuge einer umfassenden VRE vielleicht nur schwer bestehen können.

- Nur wenige VREs haben bisher strukturierte Überlegungen im Hinblick auf Kostenstrukturen und Geschäftsmodelle angestellt, was damit zusammenhängt, dass die Betriebsphase einer VRE, in der Nachhaltigkeit relevant wird, bisher nur selten erreicht wurde.

- Der Erfolg einer VRE hängt entscheidend von der frühzeitigen Einbindung der späteren Nutzercommunity ab. Dabei ist unter Einbindung die aktive Mitarbeit von Multiplikatoren und „entwicklungskompetenten“ Nutzern zu verstehen, die bei der Anforderungserhebung, aber auch bei der Entwicklung wertvolle Unterstützung leisten können.

- Der Erfolg einer VRE hängt ebenfalls von einer frühzeitigen Berücksichtigung der unterschiedlichen Lebensphasen ab, da sich dies auf die Kostenstrukturen und mögliche Geschäftsmodelle entscheidend auswirkt. Dieser Punkt richtet sich nicht nur an die Entwickler einer VRE, sondern insbesondere auch an ihre Betreiber und Förderer.

Literatur und Verweise

- Stefan Buddenbohm, Harry Enke, Matthias Hofmann, Jochen Klar, Heike Neuroth, Uwe Schwiegelshohn: "Erfolgskriterien für den Aufbau und nachhaltigen Betrieb Virtueller Forschungsumgebungen" DARIAH-DE Working Papers Nr. 7. Göttingen: DARIAH-DE, 2014. URN: http://nbn-resolving.de/urn:nbn:de:gbv:7-dariah-2014-5-4

- Uwe Schwiegelshohn, Heike Neuroth, Harry Enke, Stefan Buddenbohm, Matthias Hofmann, Jochen Klar (2014): A Lifecycle Model for Collaborative Research Environments: In: GI-Edition - Lecture Notes in Informatics (LNI) 7. DFN-Forum Kommunikationstechnologien. Bonn: Köllen Verlag. Link zum Verlag

- Stefan Buddenbohm (2014): Erfolgskriterien für den Aufbau und nachhaltigen Betrieb Virtueller Forschungsumgebungen - Poster Projektergebnisse).

- Stefan Buddenbohm, Jochen Klar (2014): Lebensphasen und Erfolgskriterien für Virtuelle Forschungsumgebungen (DFG-VRE) - Vortrag im Rahmen eines Workshops zum Integrierten Monitoring bei TextGrid, Berlin, 21.11.2014).